全部语种

分享

华为、清华等开源超高清、精准文生图模型,0.5秒极速生成!

文章来源:AIGC开放社区

华为诺亚方舟实验室、清华大学信息科技学院、大连理工、香港大学和Hugging Face的研究人员,联合开源了超高清文生图模型——PIXART-δ。

研究人员将潜在一致性模型(LCM)和创新控制架构ControlNet-Transformer集成在PIXART-δ中,在文生1024*1024高质量图像方面实现了重大技术突破,仅用0.5秒2-4个推理步骤就能完成图像生成,这也比之前的PIXART-{\alpha}模型快了7倍。

此外,PIXART-δ在ControlNet-Transformer帮助下,可以在不同条件下对生成模型的输出进行精确控制,例如,图像的边缘、深度、分割和对象姿势等,有点类似OpenAI的DALL·E 3。

开源地址:https://github.com/PixArt-alpha/PixArt-alpha

论文地址:https://arxiv.org/abs/2401.05252

在线Demo:https://huggingface.co/spaces/PixArt-alpha/PixArt-LCM

潜在一致性模型

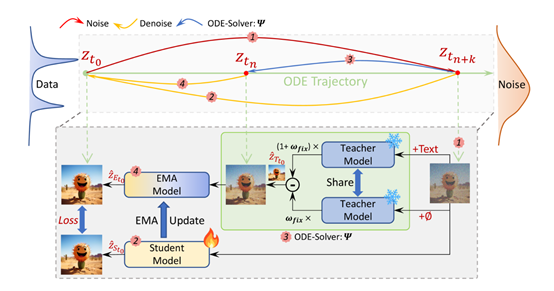

LCM是一种用于加速生成模型的全新高效方法,核心技术是将生成模型的反向采样过程,看成是解决一个增强的概率流动常微分方程(PF-ODE)流程。

传统的生成模型是通过迭代采样的方式生成图像,需要繁琐的步骤并且每个步骤都需要大量的AI计算资源和时间。

而LCM通过预测增强的PF-ODE方法,将生成过程简化为几个微小步骤,以帮助模型用最快的速度生成高质量的图像。

PF-ODE主要描述了图像生成过程中的概率流动,并将每个数据点映射回其起源点。通过求解增强的PF-ODE,使得LCM可以在潜在空间中生成高质量的图像样本。

然后,LCM利用一致映射函数进行训练。这个函数能够直接从最后一个时间点,推断出任何其他时间点上的样本位置。所以,整个扩散回归过程就可以直接通过求解概率流微分方程实现,而不是像传统模型那样需要多步迭代。

这也是为什么PIXART-δ能用2—4个推理步骤就能生产高精准图像的原因。

ControlNet-Transformer

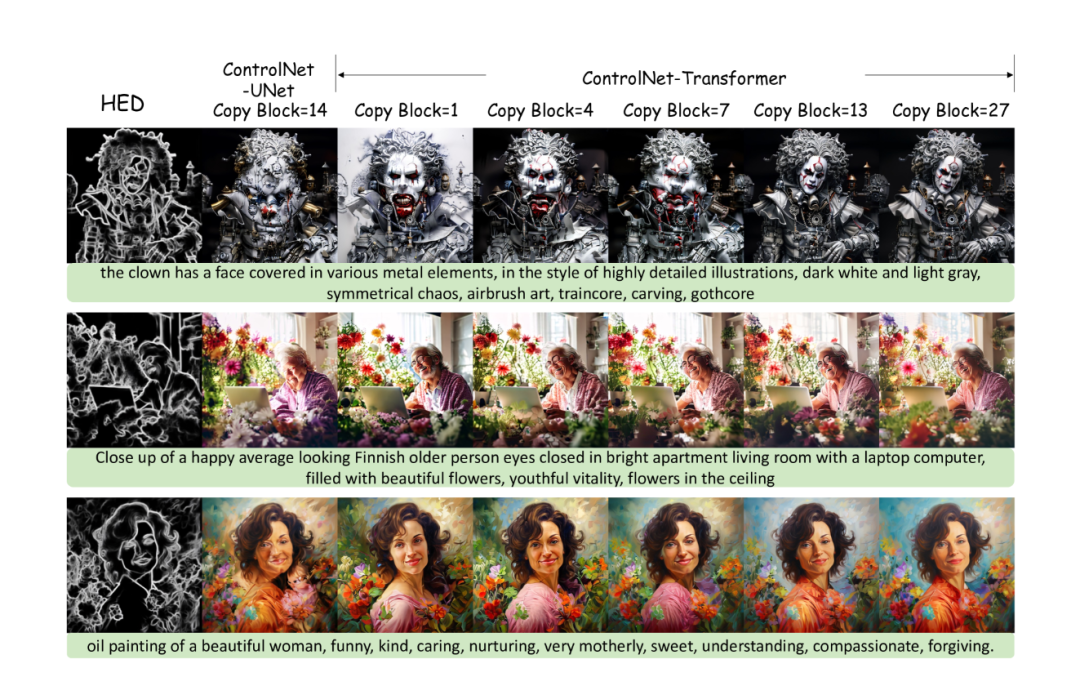

ControlNet在边缘检测、姿态估计、草图生成、表情表达等方面,展示了对文本生成图像扩散模型内容输出的优秀控制能力。

这是因为其拥有一个可训练的UNet副本,允许对输入条件进行操作,从而控制生成图像的整体布局。

在训练过程中,ControlNet冻结原始的文本到图像扩散模型,只优化可训练的副本。通过跳跃连接将该副本的每个层的输出与原始UNet集成,并使用“零填充卷积”层以避免过多的AI算力负担。

但是,ControlNet架构是针对UNet-based扩散模型精心设计的,直接复制到Transformer中效果较差。

所以,为了在Transformer架构中实现更好的精准控制能力,研究人员使用了一种创新的ControlNet-Transformer架构,并专门针对Transformer模型进行了优化和量身定制。

ControlNet-Transformer通过在解码器中的每个解码层之间引入跳跃连接,并使用适当的注意力机制,使得生成的图像既具有高质量的细节,又能根据输入的条件进行灵活的调整和控制。

PIXART-δ生成案例赏析

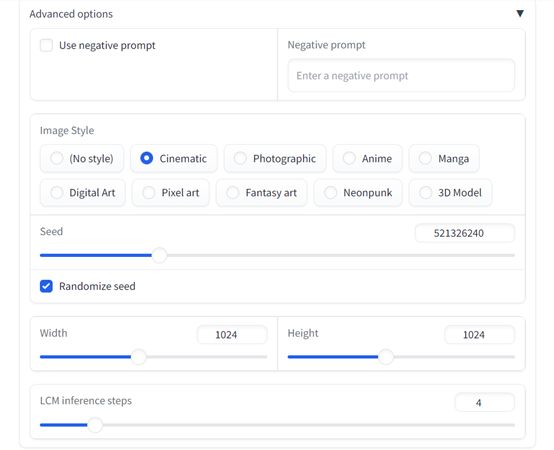

以下是「AIGC开放社区」根据在线Demo生成的图像,整体来说生成效率非常高,语义还原精准,并且支持可视化生成流程控制,例如,生成步骤、图像尺寸、图像类型等,功能强大且易使用。

一只戴着别致绅士帽、穿着夹克的拟人猫,站在秋天的森林中的肖像照。

美丽的女孩,雀斑,笑容灿烂,蓝色的眼睛,姜黄色的短发,深色的妆容,穿着花蓝色背心,柔和的光线,深灰色的背景,写实风格。

桌子上透明罐子里壮观的微小世界,大会堂内部,精心设计,雕刻建筑,解剖,象征,几何和参数化细节,精确的平面线细节,图案,黑暗幻想和难以表达的神秘情绪,技术设计,复杂的超细节,风格化和未来主义和仿生细节,建筑概念,低对比度细节,电影照明,8K,虚幻,逼真,超现实。

一艘海盗船被困在宇宙漩涡星云中,在宇宙海滩漩涡引擎中渲染,体积照明,壮观,环境光,光污染,电影氛围,新艺术风格,4K,复杂的细节和纹理。